解释模型行为的最新技术

全面支持多种模型和算法类型,涵盖训练和推理过程

社区驱动的开源工具包

模型可解释性帮助组织中的开发者、数据科学家和业务利益相关者全面理解他们的机器学习模型。它还可以用于调试模型、解释预测,并支持审计以符合监管要求。

通过开放统一的 API 集和丰富的可视化效果,访问最先进的可解释性技术。

使用各种解释器和技术,通过交互式可视化来理解模型。选择你的算法并轻松实验算法组合。

探索模型属性,例如性能、全局和局部特征,并同时比较多个模型。操作数据并查看对模型的影响时,运行假设分析。

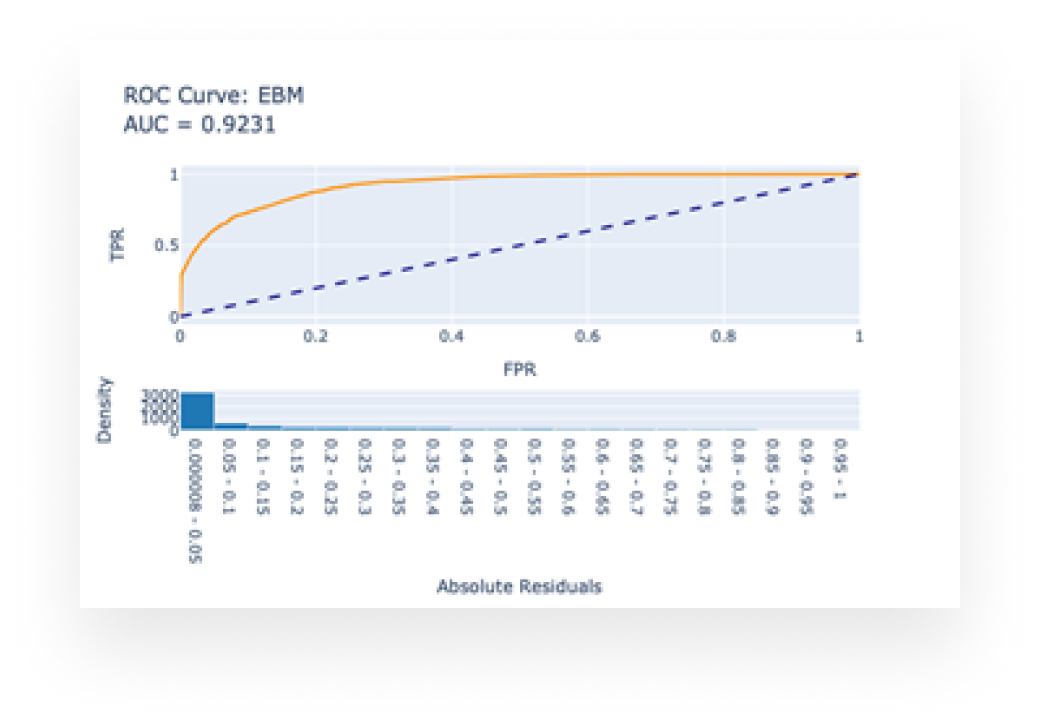

白盒模型由于其结构而具有可解释性。示例包括:可解释提升机 (EBM)、线性模型和决策树。

白盒模型提供无损解释,并且可以由领域专家编辑。

黑盒模型难以理解,例如深度神经网络。黑盒解释器可以分析输入特征和输出预测之间的关系来解释模型。示例包括 LIME 和 SHAP。

使用全局特征重要性,探索整体模型行为并找到影响模型预测的关键特征。

使用局部特征重要性,解释单个预测并找到影响它的特征。

使用群组特征重要性,解释预测的子集。

使用假设分析等技术,查看输入特征的变化如何影响预测。

理解模型,调试或发现问题,并将模型解释给其他利益相关者。

在模型部署前对其进行验证,并在部署后进行审计。

理解模型的行为方式,以便向客户提供关于预测的透明度。

轻松集成新的可解释性技术,并与其他算法进行比较。